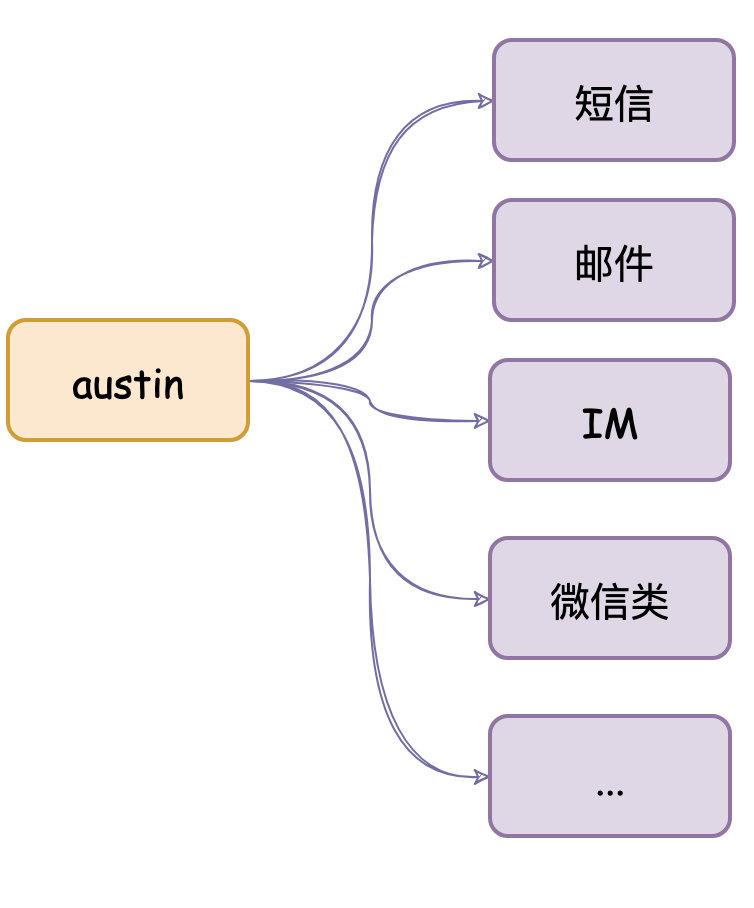

austin项目核心功能:统一的接口发送各种类型消息,对消息生命周期全链路追踪。

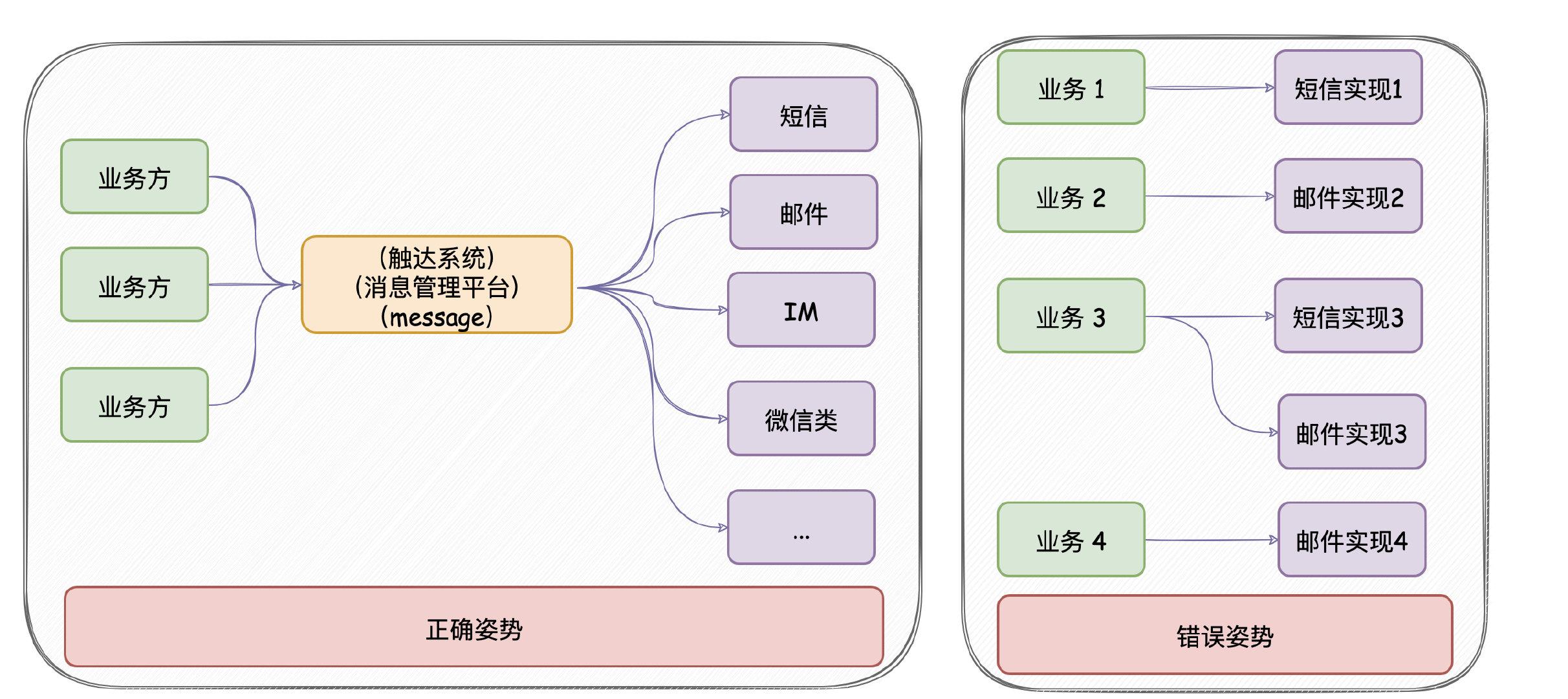

项目出现意义:只要公司内有发送消息的需求,都应该要有类似austin的项目,对各类消息进行统一发送处理。这有利于对功能的收拢,以及提高业务需求开发的效率。

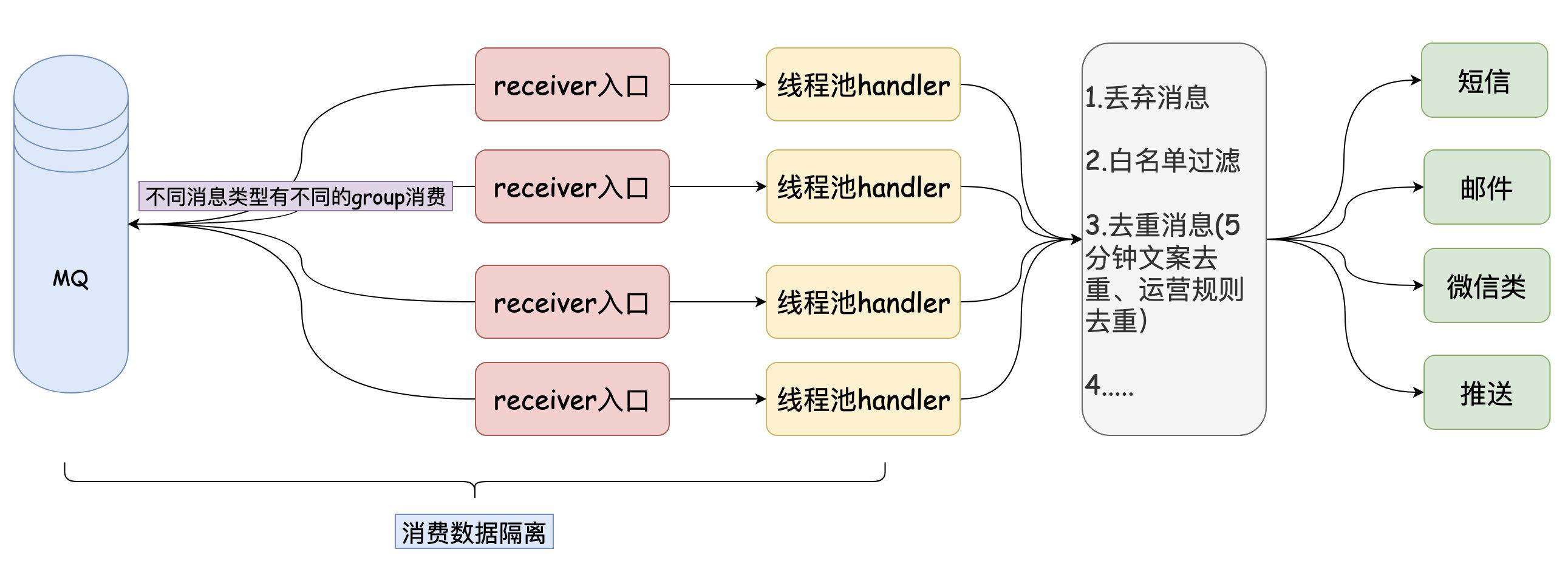

austin项目核心流程:austin-api接收到发送消息请求,直接将请求进MQ。austin-handler消费MQ消息后由各类消息的Handler进行发送处理。

Question :为什么发个消息需要MQ?

Answer:发送消息实际上是调用各个服务提供的API,假设某消息的服务超时,austin-api如果是直接调用服务,那存在超时风险,拖垮整个接口性能。MQ在这是为了做异步和解耦,并且在一定程度上抗住业务流量。

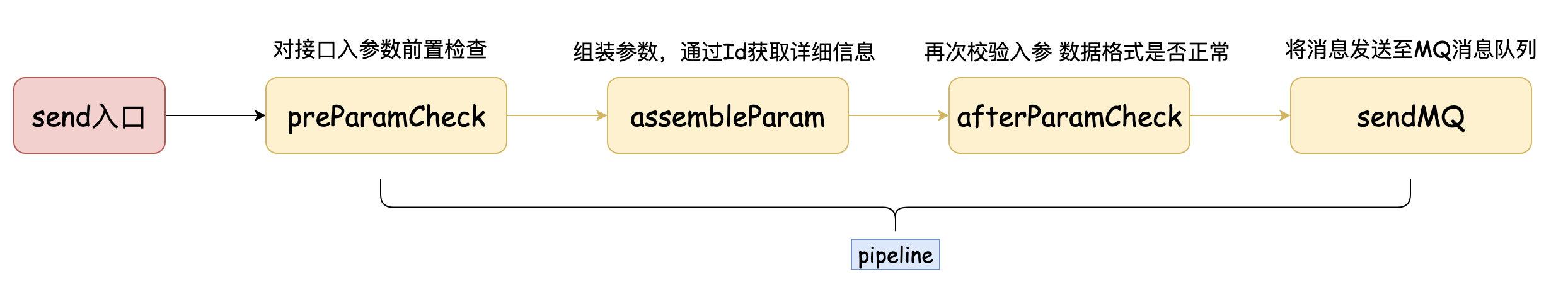

Question:能简单说下接入层做了什么事吗?

Answer:

Question:austin-stream和austin-datahouse的作用?

Answer:austin-handler在发送消息的过程中会做些通用业务处理以及发送消息,这个过程会产生大量的日志数据。日志数据会被收集至MQ,由austin-stream流式处理模块进行消费并最后将数据写入至austin-datahouse

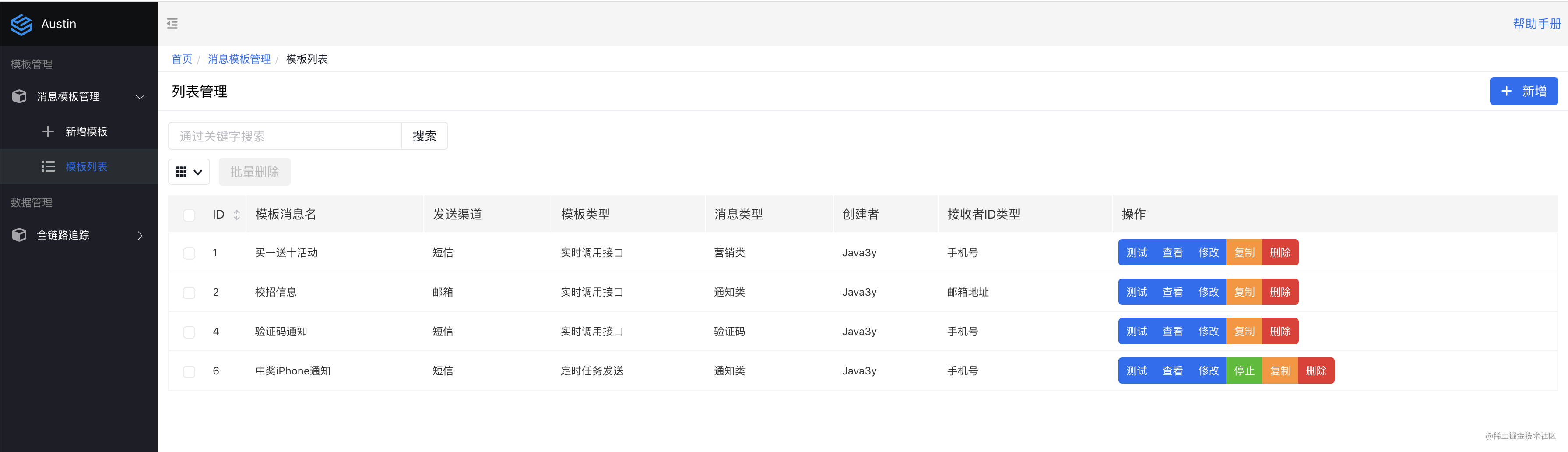

Question:austin-admin和austin-web和austin-cron的作用?

Answer:autsin-admin是austin项目的前端项目,可通过它实现对管理消息以及查看消息下发的情况,而austin-web则是提供相关的接口给到austin-admin进行调用(austin项目是前后端分离的)

业务方可操作austin-admin管理后台调用austin-web创建定时发送消息,austin-cron就承载着定时任务处理的工作。

目前引用的中间件教程的安装姿势均基于Centos 7.6(完全部署所有的服务,大概8G内存),austin项目强依赖MySQL/Redis/Kafka/apollo,弱依赖prometheus/graylog/flink/xxl-job。

1、austin使用的MySQL版本5.7x。如果目前使用的MySQL版本8.0,注意改变pom.xml所依赖的版本

2、填写application.properties中austin-database对应的ip/port/username/password信息

3、执行sql文件夹下的austin.sql创建对应的表以及插入测试数据

4、填写application.properties中austin-kafka对应的ip/port信息

5、填写application.properties中austin-redis对应的ip/port信息

6、检查apollo的app.id/apollo.bootstrap.namespaces,检查创建的消息队列topic:austin.business.topic.name

7、以上配置信息都在application.properties文件中修改。

8、由于使用了Apollo且我是在云服务器上安装的,我这边会直接跳过metaserver服务发现,在AustinApplication需要配置对应的apollo地址(注意端口!)

9、发送渠道账号的信息都配置在apollo,配置的示例参照com.java3y.austin.support.utils#getAccount中的注释

10、调用http接口com.java3y.austin.web.controller#send给自己发一条短信或者邮件感受

curl -XPOST "127.0.0.1:8080/send" -H 'Content-Type: application/json' -d '{"code":"send","messageParam":{"extra":null,"receiver":"13719333899"},"messageTemplateId":1}'11、austin前端管理系统部署(一分钟即能打开)

12、正常使用数据管理(查看实时数据链路下发)需要将austin-stream的jar包上传至Flink,根据部署文档启动Flink。在打jar包前需要填写com.java3y.austin.stream.constants.AustinFlinkConstant中的redis和kafka的ip/port(注:日志的topic在application.properties中的austin.business.log.topic.name。如果没有该topic,需要提前创建)

13、正常使用定时任务需要部署xxl-job,根据部署文档启动xxl的调度中心,并在application.properteis中填写 austin-xxl-job-ip和austin-xxl-job-port

14、正常使用分布式日志采集需要部署graylog,根据部署文档启动graylog,并在application.properteis中填写 austin-grayLog-ip

14、正常使用系统监控需要部署promethus和grafana,根据部署文档配置grafana图表

Maven+SpringBoot项目搭建

logback日志记录项目运行时信息,引入common/guava/Hutool/Lombok/fastjson/OkHttp工具包

接入腾讯云渠道发送一条短信

使用SpringData JPA将短信发送记录存储至MySQL

使用SpringBoot接入Kafka

利用责任链完成对接入层的请求进行封装(责任链模式)

消费层实现数据隔离(线程池:生产者与消费者模式)

通用去重消息功能(SpringBoot接入Redis并使用pipeline减少网络请求)

配置服务器和docker容器以及SpringBoot应用的监控(prometheus+Grafana+auctuator)

接入分布式配置中心完成 丢失消息、白名单以及账号配置(Apollo分布式配置中心)

邮件渠道接入

日志链路数据追踪 + 注解式打印日志(优雅打印日志以及数据埋点)

接入GrayLog分布式日志收集框架

引入前端低代码平台AMIS搭建后台管理页面

接入分布式定时任务框架定时发送任务(xxl-job定时任务框架),编写上传文件接口并使用LazyPending批处理人群文件数据

接入实时流计算平台(Flink),实时日志数据根据用户维度和消息模板维度清洗至Redis

通过AMIS低代码平台接入echarts图表展示实时聚合后的数据

优雅停机、动态线程池参数配置

企业微信渠道接入

夜间屏蔽次日早晨推送(xxl-job定时任务框架,另类的延时队列)

钉钉渠道接入

单机限流实现

引入单测框架,编写部分单测用例

接入微信服务号渠道(已有pull request代码)

接入微信小程序渠道(已有pull request代码)

接入PUSH渠道

总体架构已完成,持续做基础建设和优化代码

标签:

austin消息推送平台v1.0 源码链接:https://www.hycodes.cn/xtbg/434.html

下载说明:本站部分资源供学习交流使用,如商业用途,请购正版。

下一篇:多聚合可视化工作流系统